今年は晴天で過去一番の初日の出を見ることができました。 去年は様々なイベントがあ…

Ubigi eSIMを使った

ものすごく久しぶりに海外に行ったのですが、最近は海外で通信する際もeSIMを使用…

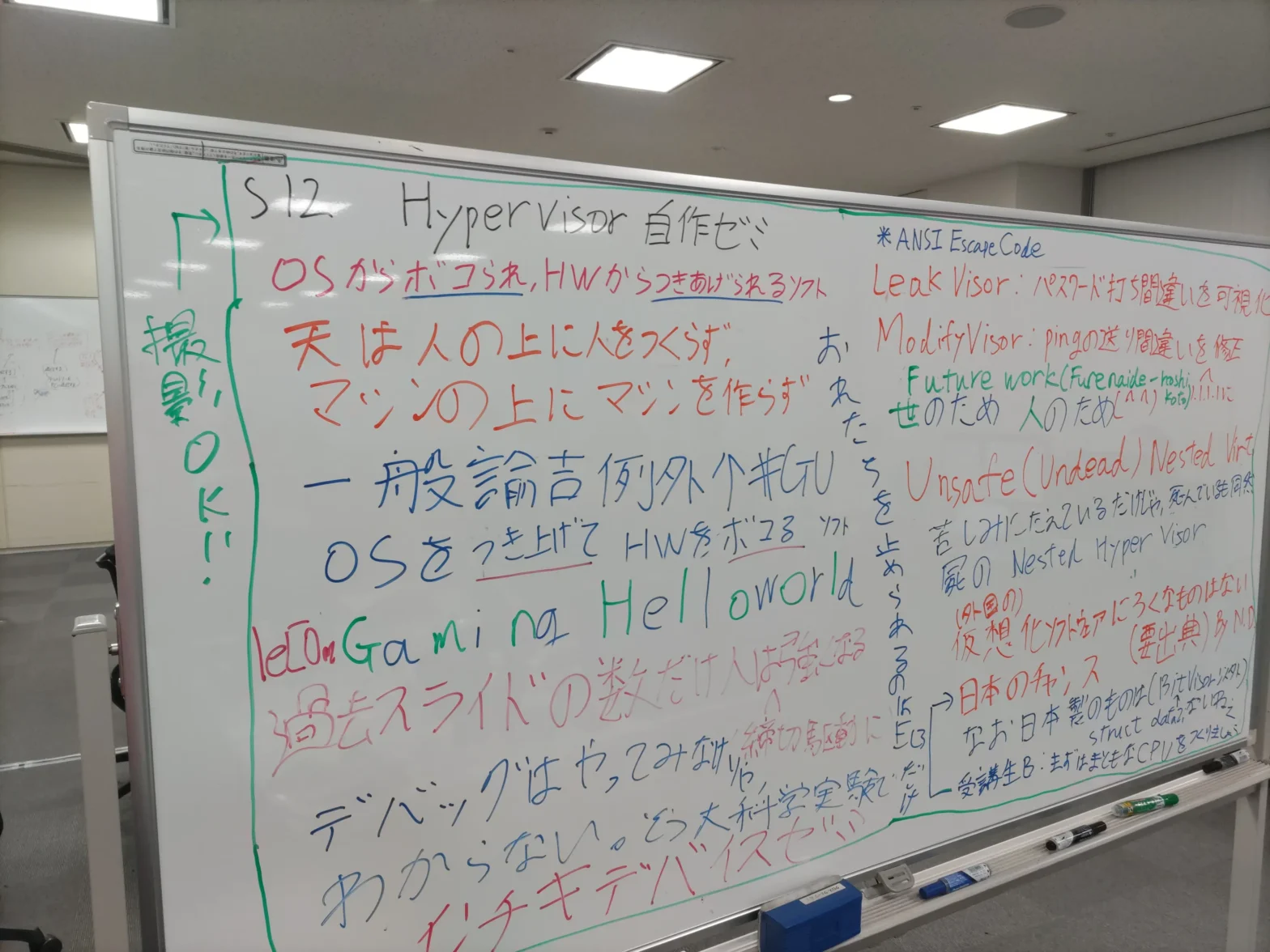

セキュリティキャンプ2024 参加記(講師)

ドッタンバッタン大騒ぎして結局今までろくにまとめられなかったセキュリティキャンプ…

TELECUBE/EXPRESS WORK/STATION BOOTHを使った

忙しくしていたらあっという間に4月らしく、学会発表やら就活やらが無事終了してた。…

openSUSEでX11依存を極力なくす

KDE Plasma6が出てきて、時代はWaylandになったわけです。長らく、…

Dynadot EMail Proを使ってみた

最近手が回ってないと言ってたら、数年経っていた人です。いやほんとに、手が回ってな…

あけましておめでとうございます。

今年は曇天のため、初日の出は見れませんでした。本日の予定は終了です。 去年はコー…

PCI BARの値とACPIの_CRS関数

この投稿は、Kernel/VM探検隊@北陸 Part 6で発表を行った「AArc…

セキュリティキャンプ2023 参加記(講師)

ドッタンバッタン大騒ぎして結局今までろくにまとめられなかったセキュリティキャンプ…

Open Build System(OBS)で依存関係のソースのリポジトリを指定する

普段、サーバでNAXSIというWeb Application Firewallを…